- AI大模型助你輕松搞定數據分析

- 吳曇編著

- 7字

- 2025-08-07 18:00:51

1.1 什么是大模型

1.1.1 大模型概述

小紅剛剛畢業,帶著對數據分析的濃厚興趣和熱情,加入了一家互聯網公司。盡管在大學期間已經接觸過一些數據分析知識,并通過實際項目運用這些知識解決過問題,但她對于在公司里如何開展數據分析工作仍感到有些困惑。

今天是小紅第一天上班,她走進公司,看著陌生的環境,心中有些忐忑。吳老師熱情地迎接了她,吳老師是公司里的數據分析專家,也是小紅的指導老師。吳老師幫小紅準備好了辦公用品,開通了她所需的數據和文檔權限。

吳老師:我們從現在開始要學習一個工具,這個工具可能會伴隨你的整個職業生涯,是你工作中的得力助手。讓我們想象一下,如果有一個智能助手,它幾乎掌握了世界上所有的知識,你可以隨時和它對話,它可以幫你實時搜索信息,進行多語言編程、翻譯和寫作,進行邏輯推理、共同創作,甚至還能調用其他軟件幫你完成任務。聽起來是不是很神奇?

小紅眼睛一亮:太棒了,這簡直就像發現了新寶藏!

吳老師:現實中真有這么一個寶藏,它就是大模型。它可以成為你的助手、翻譯官、程序員、咨詢顧問、搜索引擎等。讓我們一起深入了解它,讓它助力你的數據分析之旅。

小紅好奇地瞪大了眼睛。

吳老師:在數據分析方面,我們常使用GPT大模型,市面上有很多GPT大模型產品,比如深度求索的DeepSeek、OpenAI的ChatGPT、月之暗面的Kimi、百度的文心一言、字節跳動的豆包、阿里巴巴的通義千問、智譜清言等。

小紅:這么多GPT產品,我應該選擇哪種呢?

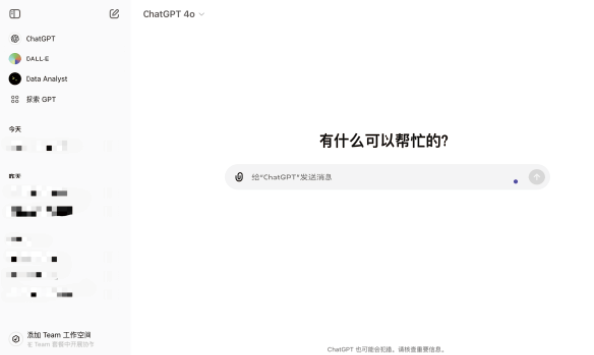

吳老師:選任何一種或者同時用幾種都可以,先找到自己與GPT互動的方式。這分別是ChatGPT(見圖1-1)與DeepSeek(見圖1-2)的界面,我們在文本框中輸入問題,等待它的回答即可。我們可以先讓GPT介紹一下自己。

圖1-1

圖1-2

提問:

介紹一下GPT是什么,能做什么。

GPT(Generative Pre-trained Transformer)是一種基于變換器(Transformer)架構的大語言模型(Large Language Model,LLM),由人工智能研究實驗室OpenAI開發。GPT模型的核心是利用Transformer架構來處理和生成自然語言文本。

主要特點

(1)大規模參數:GPT模型擁有數億甚至數千億的參數,這使得它能夠捕捉到語言的細微差別和復雜關系。

(2)Transformer架構:GPT基于Transformer模型,這是一種特別擅長處理序列數據(如文本)的深度學習模型。

(3)預訓練和微調:GPT通常首先在大規模的文本數據集上進行預訓練,學習語言的通用模式,然后針對特定任務進行微調。

(4)上下文感知:GPT能夠理解文本的上下文信息,這使得它在生成文本或回答問題時更加準確。

能做的事情

(1)文本生成:生成文章、故事、詩歌等文本內容。

(2)對話:與用戶進行自然語言對話,回答問題、提供信息、進行閑聊等。

(3)文本摘要:提取文本的主要內容,生成摘要。

(4)翻譯:將一種語言的文本翻譯成另一種語言。

(5)編程輔助:提供編程相關的幫助,如代碼示例、調試建議等。

(6)教育輔助:幫助學習者理解復雜概念,提供教學資料等。

(7)創意寫作:協助用戶進行創意寫作,提供靈感和建議。

(8)數據分析:幫助分析數據,提供數據處理和可視化建議。

小紅:GPT回答的時候好像打字一樣,一個字一個字地出來的呢。

吳老師:這是因為GPT是基于Transformer的,我一點點來展開講。首先,先搞清楚什么是GPT。

小紅:好的。

吳老師:GPT的全稱是Generative Pre-trained Transformer。Generative是生成式,表示它能夠生成文本;Pre-trained是預訓練,意味著它在大量的文本數據上進行了預訓練;Transformer是一種深度學習模型的架構。GPT是一種基于Transformer架構的大語言模型。

小紅:什么又是大語言模型呀?

吳老師:這個問題非常好,要想了解GPT,就要先了解大語言模型。大語言模型(簡稱“大模型”)是深度學習的一種應用,專門用于進行自然語言處理任務。關于機器學習、深度學習等的知識,后續用到再詳細說明。

小紅:我有一個問題,大語言模型“大”在哪里呢?是指訓練數據量巨大嗎?

吳老師:大語言模型的“大”指的不僅僅是訓練數據量巨大,還有參數數量巨大。什么是參數呢?參數是模型內部的變量,可以理解為模型在訓練過程中學到的知識。簡單來說,參數就像是模型的“腦細胞”。你可以這么想,參數越多,模型的“大腦”能學習到的東西越多,變得越來越聰明。這就像要模型學習做蛋糕,只允許模型調整面粉、糖和雞蛋的量,以及允許模型調整面粉、糖、雞蛋、奶油、黃油、牛奶、小蘇打粉、可可粉的量及烤制的時長和溫度,后者由于可以調整的變量更多,更能讓模型做出好吃的蛋糕。當然,對模型來說這不是絕對的,但按照GPT這種模型的邏輯,參數越多能夠讓它越智能。

小紅:那GPT有多少個參數呀?

吳老師:這是一個好問題。以OpenAI的第一個大模型GPT-1為例,它有1.17億個參數,到了GPT-2,參數有15億個,而 GPT-3的參數又增長到了1750億個。這讓大模型不像小模型那樣局限于單項或某幾項任務,它的功能十分強大。

小紅驚訝地說:竟然有千億個參數,怪不得這么聰明。

吳老師:AI突然變聰明,在技術上有一個詞叫作“涌現”,涌現是一個很有意思的概念。想象一下,當AI系統能分析與處理海量的數據后,突然有一天,它就像穿越了一個魔法門,變得超級聰明,擁有了和人一樣的高級智慧。這個過程就好比它從一個只會做簡單計算的小助手,變成了能和你辯論哲學的大師。這種變化就是我們說的“涌現”。GPT系列大模型的發布,開創了AI技術共享和應用的新紀元。

小紅:原來GPT是技術涌現的成果。這真是太神奇了,我們用數據和算法構建了一個可以理解和預測的世界,就仿佛人類的智慧有了延伸。